История развития видеокарт: революции и эволюции графических технологий

Видеокарты — неотъемлемая часть современных компьютеров, отвечающая за отображение графики. Однако их история уходит корнями в несколько десятилетий назад, когда они начинали с базовых функций отображения символов и текстов. В этой статье мы пройдемся по основным этапам развития видеокарт, расскажем, зачем они нужны, как работают, и остановимся на знаковых моделях, которые стали настоящими революционерами в своей отрасли.

Зачем нужны видеокарты?

Основная задача видеокарты заключается в обработке и выводе графической информации на дисплей. Это может быть как обычная текстовая информация, так и сложные трёхмерные изображения, требующие больших вычислительных мощностей. Современные видеокарты используют для работы игры, профессиональные программы для видеомонтажа, 3D-моделирования и даже искусственный интеллект. Всё это требует быстрой и эффективной обработки огромных объёмов данных.

Ранние компьютеры имели лишь базовые возможности для отображения графики. Они могли выводить текст и символы на экран, но не могли обрабатывать сложные графические задачи. Именно для этого и были разработаны видеокарты — специализированные устройства для ускорения графической обработки, освобождающие центральный процессор от этих задач и обеспечивающие пользователям качественное графическое отображение.

Как работают видеокарты?

Видеокарта состоит из нескольких ключевых компонентов: графического процессора (GPU), видеопамяти, системы охлаждения и интерфейсов для подключения монитора. Основную работу выполняет GPU, который обрабатывает графические данные, преобразовывая их в сигналы, понятные монитору. Видеопамять используется для хранения этих данных до их обработки. Современные видеокарты также включают в себя различные технологии оптимизации, такие как трассировка лучей (ray tracing), поддержка высоких разрешений и других графических технологий, которые делают картинку более реалистичной и детализированной.

Первые шаги: графические адаптеры 1980-х годов

Начало 1980-х годов стало переломным моментом для графической обработки. Компании начали разрабатывать специализированные графические адаптеры, которые могли отображать больше, чем просто текст. Одним из первых значительных достижений был MDA (Monochrome Display Adapter), выпущенный IBM в 1981 году. Этот адаптер позволял выводить текст и символы на экран в одном цвете.

Следующим этапом стал CGA (Color Graphics Adapter), который появился в 1981 году и предложил возможность отображения четырёх цветов одновременно при разрешении 320x200 пикселей. Хотя по современным меркам это выглядело примитивно, CGA стал важным шагом вперёд в развитии компьютерной графики.

Революция 1990-х годов: 2D и 3D-ускорители

В 1990-х годах видеокарты начали становиться более мощными и функциональными. Ключевым моментом стало появление первых графических ускорителей. В этот период на рынок вышла компания 3dfx Interactive со своей моделью Voodoo Graphics, выпущенной в 1996 году. Эта видеокарта стала первой в своём роде, предложив пользователям возможность аппаратного ускорения 3D-графики. Игры того времени, такие как Quake и Tomb Raider, существенно изменились благодаря Voodoo, предложив гладкую и детализированную трёхмерную графику.

Однако, Voodoo могла работать только в 3D-режиме, и пользователям приходилось использовать её вместе с обычной 2D-картой. Несмотря на это, успех Voodoo ускорил развитие графических технологий, и вскоре конкуренты, такие как NVIDIA и ATI (ныне AMD), начали разрабатывать свои решения.

2000-е годы: эпоха NVIDIA и ATI

В начале 2000-х рынок видеокарт стал ареной битвы двух гигантов — NVIDIA и ATI. Одна из самых знаковых видеокарт того времени — NVIDIA GeForce 256, выпущенная в 1999 году, считается первой видеокартой, которая интегрировала все функции обработки графики (в том числе геометрические преобразования и освещение) на одном чипе. Это позволило уменьшить нагрузку на процессор и открыло дорогу к созданию более сложных трёхмерных сцен.

ATI, в свою очередь, в 2002 году выпустила свою знаменитую серию Radeon 9700, которая стала серьезным конкурентом GeForce. Radeon 9700 предложила улучшенные функции обработки графики и стала первой картой, которая поддерживала шейдеры второй версии, что дало разработчикам игр новые возможности для создания реалистичных эффектов освещения и текстур.

2010-е годы: развитие технологий и трассировка лучей

2010-е годы ознаменовались дальнейшими улучшениями графической производительности. Видеокарты стали мощнее, и появилась поддержка технологий, таких как DirectX 11 и 12, которые сделали графику ещё более реалистичной. В этот период на рынке доминировала компания NVIDIA с её серией GeForce GTX.

Революционным достижением стала поддержка трассировки лучей (ray tracing), впервые реализованная на аппаратном уровне в картах GeForce RTX 20-й серии в 2018 году. Трассировка лучей позволила значительно улучшить реализм световых эффектов, сделав отражения и тени более точными и естественными. RTX-карты стали важным шагом вперёд в индустрии графики, позволяя играм и приложениям использовать мощные инструменты для создания фотореалистичных изображений.

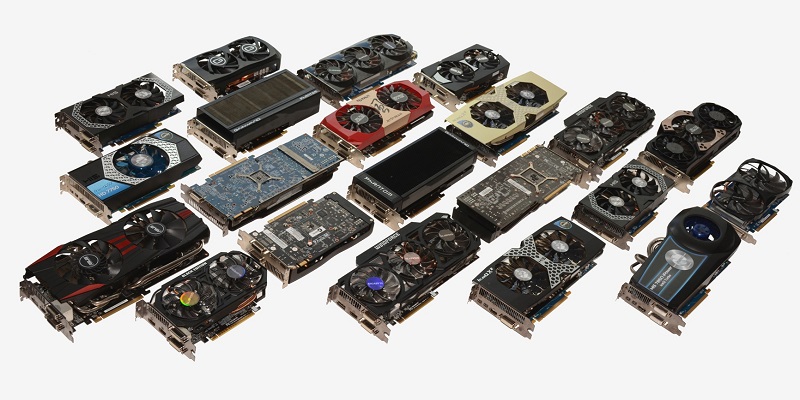

Современные видеокарты и их использование

Сегодня видеокарты используются не только для игр, но и для профессиональных задач, таких как 3D-моделирование, рендеринг видео, работа с большими данными и машинное обучение. Карты серии NVIDIA RTX и AMD Radeon RX стали выбором профессионалов и энтузиастов, предлагая высокую производительность и поддержку современных технологий.

Кроме того, развитие технологий, таких как виртуальная реальность (VR), также предъявляет высокие требования к производительности видеокарт. Видеокарты будущего обещают ещё больше улучшений в производительности, эффективности и графической реалистичности.

Заключение

История видеокарт — это история непрерывного технического прогресса. Начиная с простых адаптеров для вывода текста и заканчивая современными устройствами для рендеринга фотореалистичных 3D-сцен, видеокарты прошли долгий путь. С каждым новым поколением графические технологии становятся мощнее, открывая всё новые возможности для пользователей и разработчиков.